在行動 AI 領域的一項重大舉措中,蘋果的研究人員開源了 MobileCLIP 及其強大的後繼版本 MobileCLIP 2。這些圖文模型旨在以卓越的效率提供桌面級的性能,為新一代智慧、反應靈敏且注重隱私的裝置端應用程式鋪平了道路。

該計畫在 CVPR 2024 和權威期刊 TMLR 的論文中有詳細介紹,專注於解決 AI 的一個關鍵挑戰:在不犧牲準確性的情況下,使強大的模型變得足夠小和快,以便直接在行動裝置上運行。完整的程式碼、預訓練模型和資料集現已在 GitHub 和 Hugging Face 上向公眾開放。

性能一覽

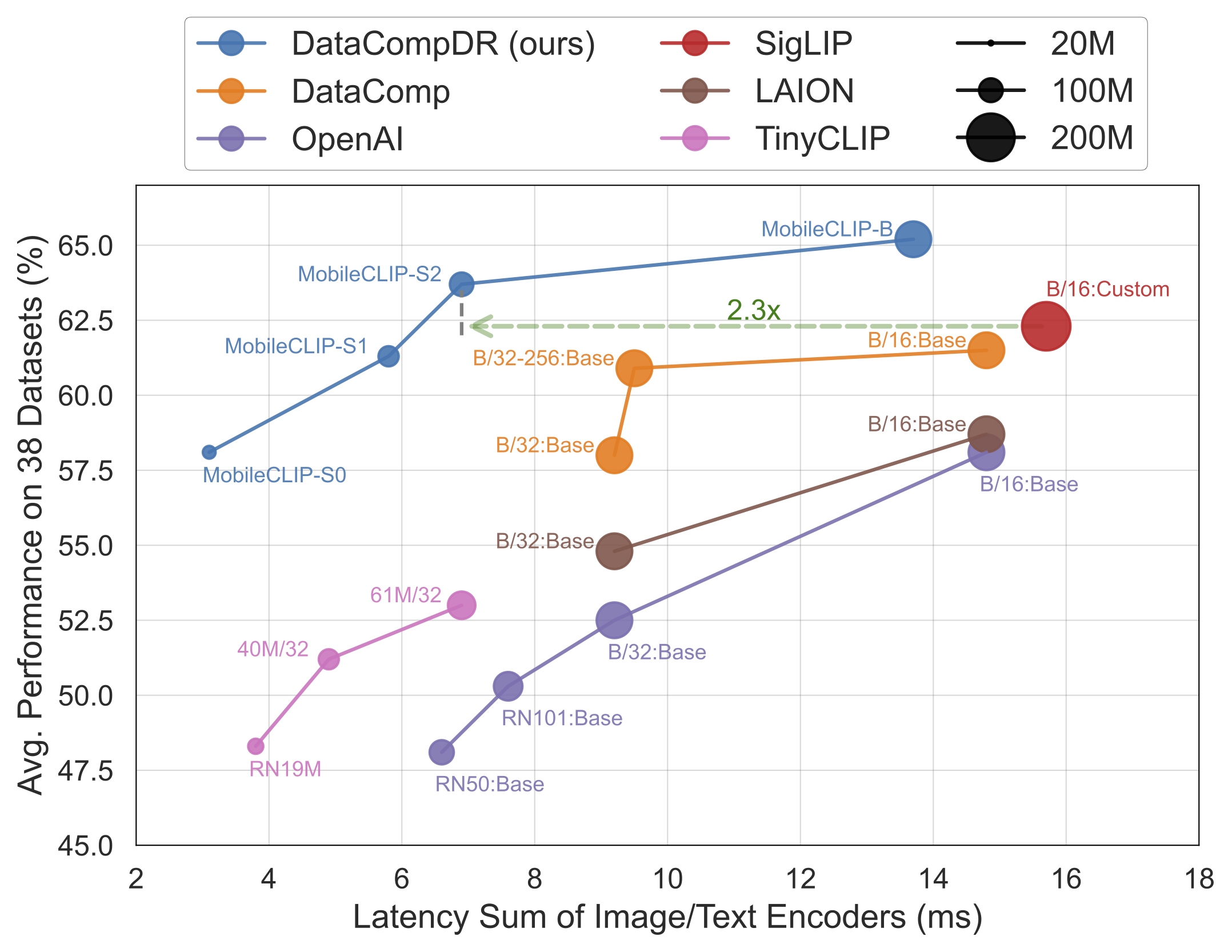

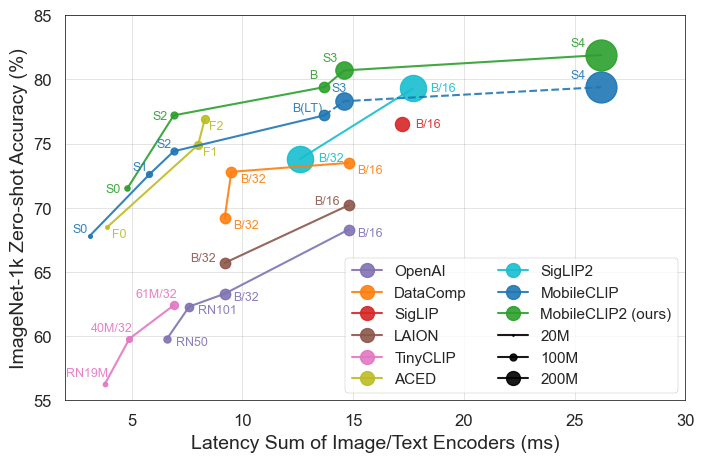

結果不言而喻。MobileCLIP 模型在 iPhone 12 Pro Max 等行動硬體上的運行速度明顯更快,同時其性能持續優於或媲美更大、計算成本更高的模型。

本次發布的主要亮點

- 頂尖效率:最小的模型

MobileCLIP-S0實現了與 OpenAI 廣泛使用的 ViT-B/16 模型相似的性能,但速度快了 4.8 倍,體積小了 2.8 倍。 - 最先進的速度:

MobileCLIP2-S4以一半的參數達到了強大的 SigLIP-SO400M/14 模型的準確度,並以 2.5 倍的較低延遲超越了 DFN ViT-L/14。 - 突破性的訓練:這些模型使用一種新穎的「多模態強化訓練」技術,在新開發的資料集(DataCompDR 和 DFNDR)上進行訓練,這是其效率提升的關鍵因素。

- 開發者友善:這些模型現在已在流行的 OpenCLIP 函式庫中獲得原生支援,使其易於整合到現有專案中。

技術深入探討

MobileCLIP 令人印象深刻的性能源於幾項關鍵創新:

- 多模態強化訓練:一種新穎的訓練策略,可增強模型有效連接圖像和文字的能力,從而以更少的資源實現更高的準確度。

- 特別策劃的資料集:這些模型在

DataCompDR和DFNDR上進行訓練,這兩個大規模資料集是專門為了提高圖文模型的穩健性和效率而生成的。 - 高效的行動架構:模型中的視覺塔基於 MobileOne 等高效架構,這些架構針對行動 CPU 和 GPU 上的高性能進行了優化。

這對開發者和消費者為何重要

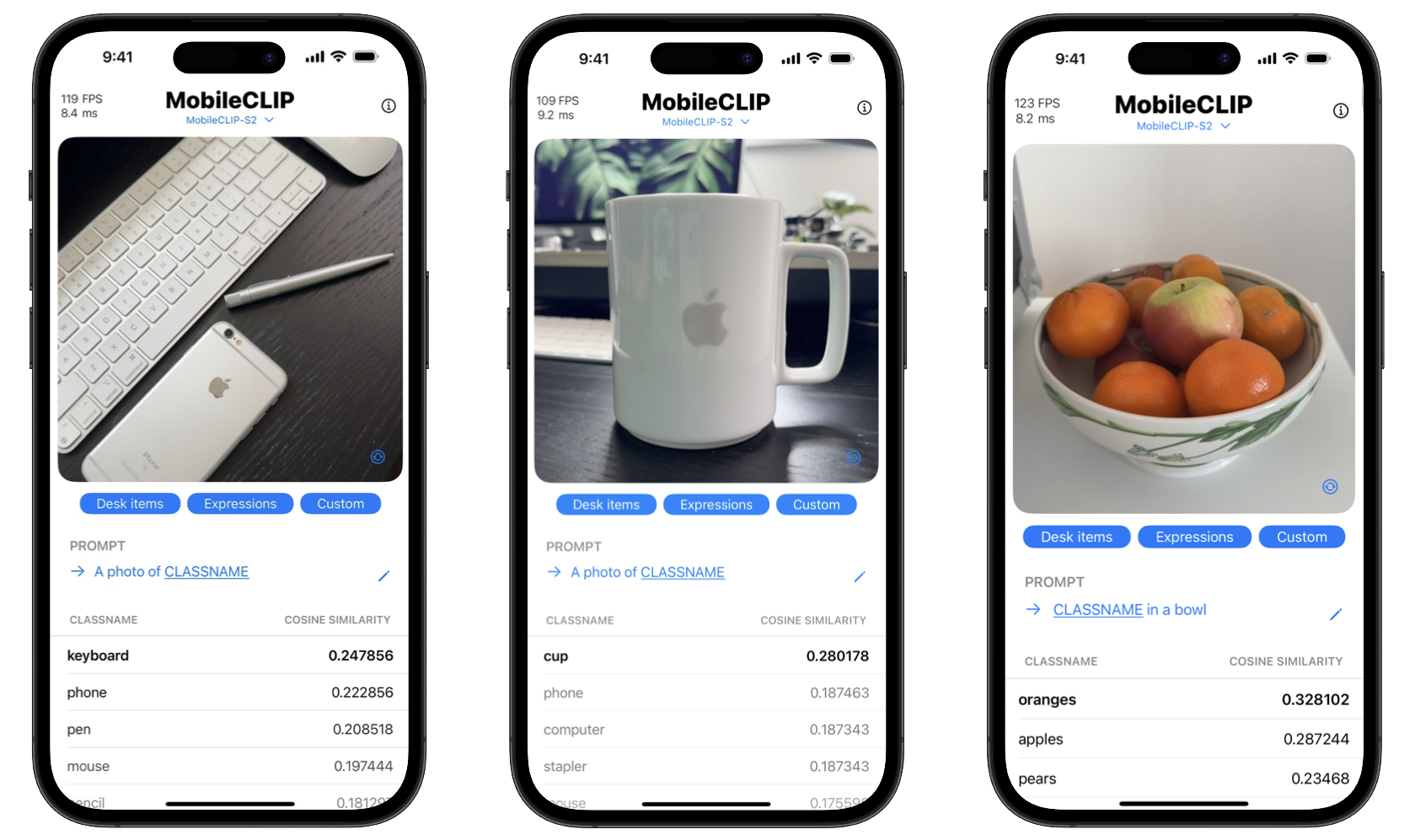

透過開源這些工具,蘋果正在賦予開發者建立複雜 AI 功能的能力,而這些功能以前只有強大的雲端伺服器才能實現。這意味著應用程式可以直接在用戶的裝置上執行即時物件辨識、視覺搜尋和進階圖像描述等複雜任務。

對消費者的好處是雙重的:隱私和速度。裝置端處理意味著個人照片等敏感資料永遠不必離開手機。此外,操作是即時的,沒有將資料發送到伺服器或從伺服器接收資料的延遲。該專案甚至包括一個 iOS 示範應用程式,以展示這些即時分類功能。

開始使用 MobileCLIP

開發者可以立即開始試用 MobileCLIP。這些模型可在 Hugging Face 上取得,完整的原始碼、訓練腳本和評估工具可在官方 GitHub 儲存庫中找到。

快速安裝

conda create -n clipenv python=3.10

conda activate clipenv

pip install -e .