모바일 AI 환경에 중요한 움직임으로, Apple 연구진은 MobileCLIP과 그 강력한 후속 모델인 MobileCLIP 2를 오픈 소스로 공개했습니다. 이 이미지-텍스트 모델들은 뛰어난 효율성으로 데스크톱 수준의 성능을 제공하도록 설계되어, 지능적이고 반응이 빠르며 개인 정보 보호가 강화된 새로운 세대의 온디바이스 애플리케이션의 길을 열어줍니다.

CVPR 2024 및 권위 있는 TMLR 저널 논문에 상세히 기술된 이 프로젝트는 AI의 중요한 과제, 즉 정확성을 희생하지 않으면서 강력한 모델을 모바일 기기에서 직접 실행할 수 있을 만큼 작고 빠르게 만드는 데 중점을 둡니다. 전체 코드, 사전 훈련된 모델 및 데이터 세트는 현재 GitHub 및 Hugging Face에서 대중에게 공개되어 있습니다.

한눈에 보는 성능

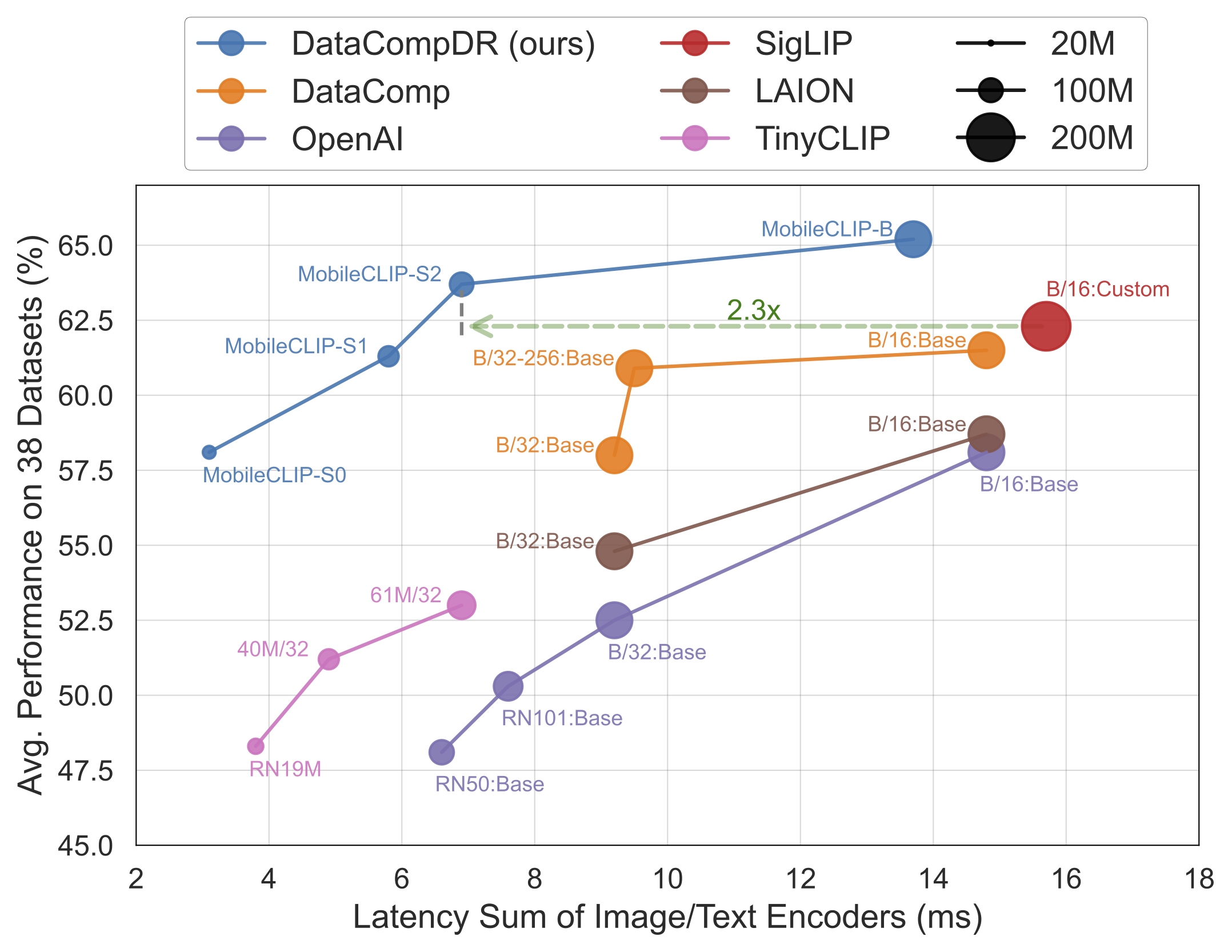

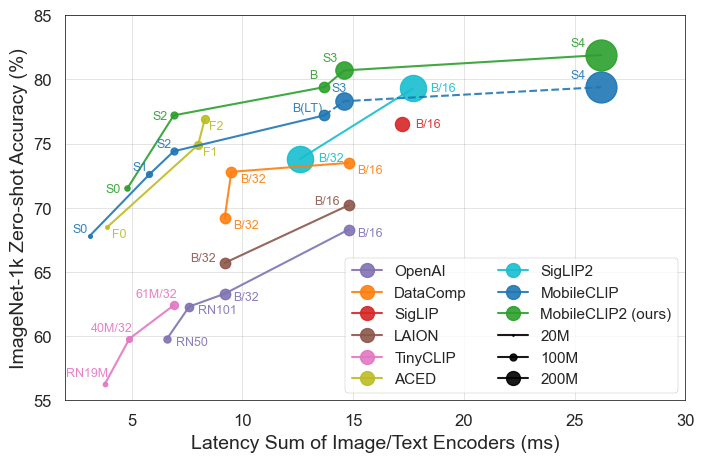

결과가 모든 것을 말해줍니다. MobileCLIP 모델들은 iPhone 12 Pro Max와 같은 모바일 하드웨어에서 훨씬 더 빠르게 실행되면서도, 더 크고 계산 비용이 많이 드는 모델들을 지속적으로 능가하거나 동등한 성능을 보입니다.

이번 공개의 주요 하이라이트

- 최고의 효율성: 가장 작은 모델인

MobileCLIP-S0는 널리 사용되는 OpenAI의 ViT-B/16 모델과 유사한 성능을 달성하면서도 4.8배 더 빠르고 2.8배 더 작습니다. - 최첨단 속도:

MobileCLIP2-S4는 강력한 SigLIP-SO400M/14 모델의 정확도와 절반의 매개변수로 일치하며, DFN ViT-L/14를 2.5배 낮은 지연 시간으로 능가합니다. - 획기적인 훈련: 이 모델들은 새롭게 개발된 데이터 세트(DataCompDR 및 DFNDR)에서 새로운 '다중 모드 강화 훈련' 기법을 사용하여 훈련되었으며, 이는 향상된 효율성의 핵심 요소입니다.

- 개발자 친화적: 이 모델들은 이제 인기 있는 OpenCLIP 라이브러리에서 기본적으로 지원되므로 기존 프로젝트에 쉽게 통합할 수 있습니다.

기술 심층 분석

MobileCLIP의 인상적인 성능은 몇 가지 주요 혁신에서 비롯됩니다:

- 다중 모드 강화 훈련: 이미지와 텍스트를 효과적으로 연결하는 모델의 능력을 향상시켜 더 적은 리소스로 더 높은 정확도를 이끌어내는 새로운 훈련 전략입니다.

- 특별히 선별된 데이터 세트: 이 모델들은 이미지-텍스트 모델의 견고성과 효율성을 향상시키기 위해 특별히 대규모로 생성된

DataCompDR및DFNDR에서 훈련되었습니다. - 효율적인 모바일 아키텍처: 모델의 비전 타워는 MobileOne과 같은 효율적인 아키텍처를 기반으로 하며, 이는 모바일 CPU 및 GPU에서 고성능을 발휘하도록 최적화되어 있습니다.

이것이 개발자와 소비자에게 중요한 이유

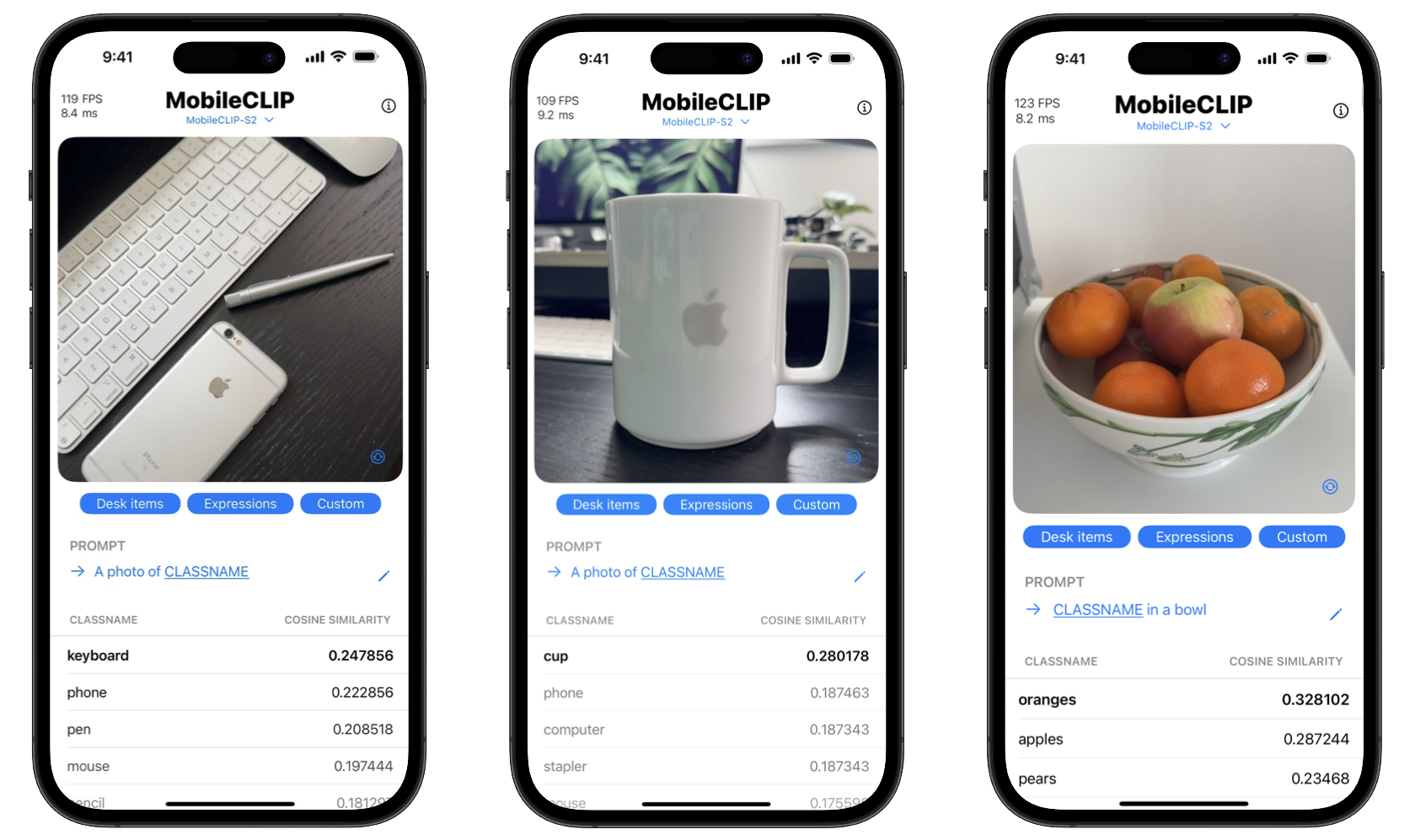

이러한 도구를 오픈 소스로 공개함으로써 Apple은 개발자들이 이전에는 강력한 클라우드 서버에서만 가능했던 정교한 AI 기능을 구축할 수 있도록 지원하고 있습니다. 이는 앱이 실시간 객체 인식, 시각적 검색, 고급 이미지 캡셔닝과 같은 복잡한 작업을 사용자의 기기에서 직접 수행할 수 있음을 의미합니다.

소비자를 위한 이점은 두 가지입니다: 개인 정보 보호와 속도. 온디바이스 처리는 개인 사진과 같은 민감한 데이터가 휴대폰을 떠날 필요가 없음을 의미합니다. 또한, 데이터를 서버로 보내고 받는 지연 없이 작업이 즉시 이루어집니다. 이 프로젝트에는 이러한 실시간 분류 기능을 보여주는 iOS 데모 앱도 포함되어 있습니다.

MobileCLIP 시작하기

개발자는 즉시 MobileCLIP 실험을 시작할 수 있습니다. 모델은 Hugging Face에서 사용할 수 있으며, 전체 소스 코드, 훈련 스크립트 및 평가 도구는 공식 GitHub 리포지토리에서 찾을 수 있습니다.

빠른 설치

conda create -n clipenv python=3.10

conda activate clipenv

pip install -e .