في خطوة مهمة لمشهد الذكاء الاصطناعي على الأجهزة المحمولة، فتح باحثون في شركة آبل مصدر MobileCLIP وخليفته القوي MobileCLIP 2. تم تصميم نماذج الصور والنصوص هذه لتقديم أداء من فئة أجهزة سطح المكتب بكفاءة ملحوظة، مما يمهد الطريق لجيل جديد من التطبيقات الذكية والسريعة الاستجابة والخاصة التي تعمل على الجهاز.

يركز المشروع، الذي تم تفصيله في أوراق بحثية لمؤتمر CVPR 2024 ومجلة TMLR المرموقة، على حل تحدٍ حاسم في مجال الذكاء الاصطناعي: جعل النماذج القوية صغيرة وسريعة بما يكفي للعمل مباشرة على الأجهزة المحمولة دون التضحية بالدقة. المجموعة الكاملة من التعليمات البرمجية والنماذج المدربة مسبقًا ومجموعات البيانات متاحة الآن للجمهور على GitHub و Hugging Face.

الأداء في لمحة

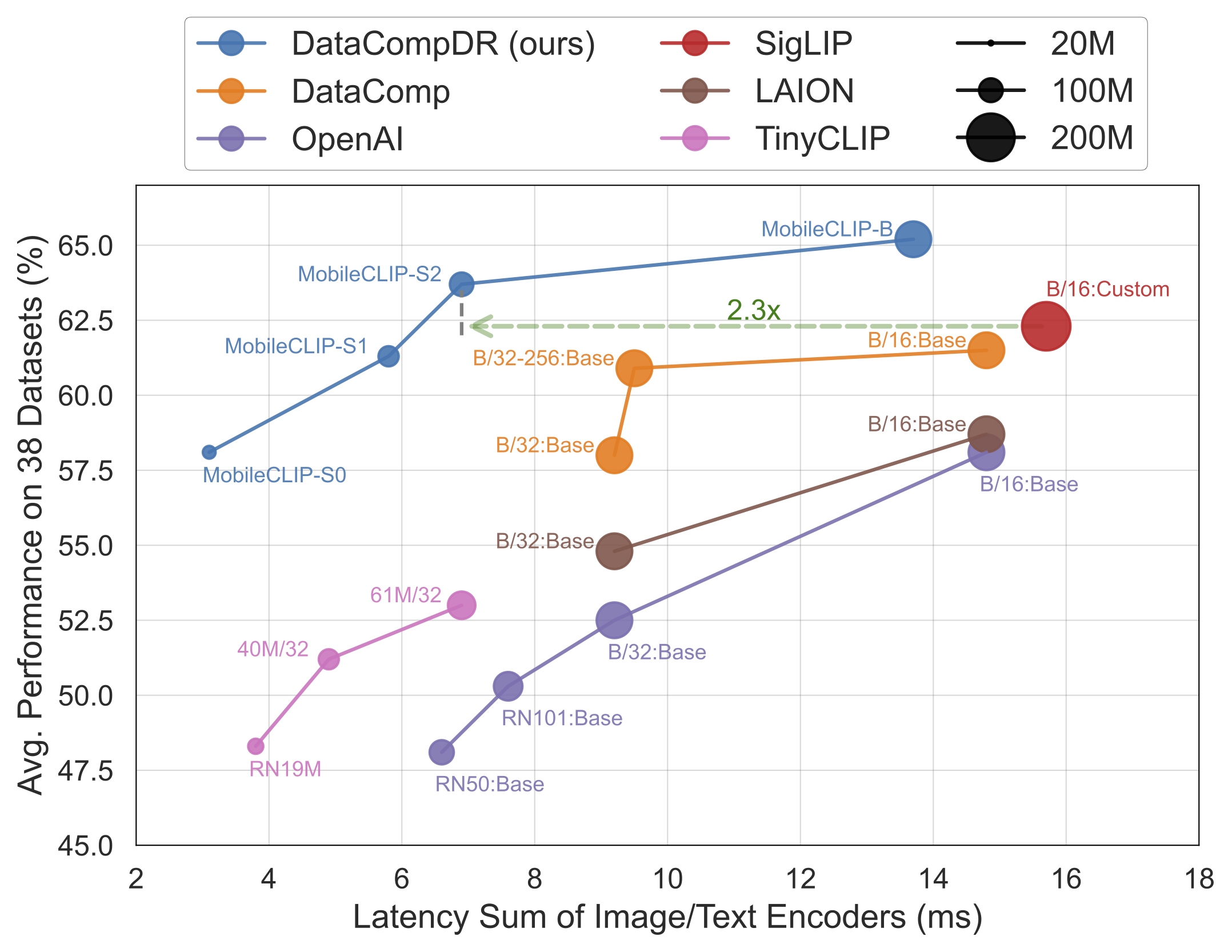

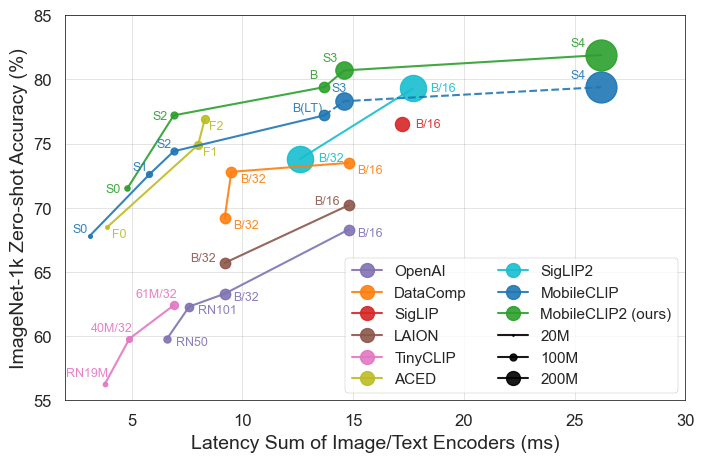

النتائج تتحدث عن نفسها. تتفوق نماذج MobileCLIP باستمرار على النماذج الأكبر والأكثر تكلفة من الناحية الحسابية أو تضاهيها، بينما تعمل بشكل أسرع بكثير على أجهزة محمولة مثل iPhone 12 Pro Max.

أبرز نقاط الإصدار

- كفاءة قصوى: أصغر نموذج،

MobileCLIP-S0، يحقق أداءً مشابهًا لنموذج ViT-B/16 المستخدم على نطاق واسع من OpenAI ولكنه أسرع 4.8 مرة وأصغر 2.8 مرة. - سرعة متطورة: يطابق

MobileCLIP2-S4دقة نموذج SigLIP-SO400M/14 القوي بنصف المعلمات ويتفوق على DFN ViT-L/14 بزمن استجابة أقل 2.5 مرة. - تدريب ثوري: يتم تدريب النماذج باستخدام تقنية "التدريب المعزز متعدد الوسائط" المبتكرة على مجموعات بيانات مطورة حديثًا (DataCompDR و DFNDR)، وهو عامل رئيسي في كفاءتها المحسنة.

- صديق للمطورين: النماذج مدعومة الآن أصلاً في مكتبة OpenCLIP الشهيرة، مما يسهل دمجها في المشاريع الحالية.

تحليل فني عميق

ينبع الأداء المثير للإعجاب لـ MobileCLIP من عدة ابتكارات رئيسية:

- التدريب المعزز متعدد الوسائط: استراتيجية تدريب جديدة تعزز قدرة النموذج على ربط الصور والنصوص بشكل فعال، مما يؤدي إلى دقة أعلى بموارد أقل.

- مجموعات بيانات منسقة خصيصًا: تم تدريب النماذج على

DataCompDRوDFNDR، وهي مجموعات بيانات ضخمة تم إنشاؤها على نطاق واسع خصيصًا لتحسين متانة وكفاءة نماذج الصور والنصوص. - بنى محمولة فعالة: تعتمد أبراج الرؤية في النماذج على أبنية فعالة مثل MobileOne، والتي تم تحسينها لتحقيق أداء عالٍ على وحدات المعالجة المركزية ووحدات معالجة الرسومات المحمولة.

لماذا يهم هذا المطورين والمستهلكين

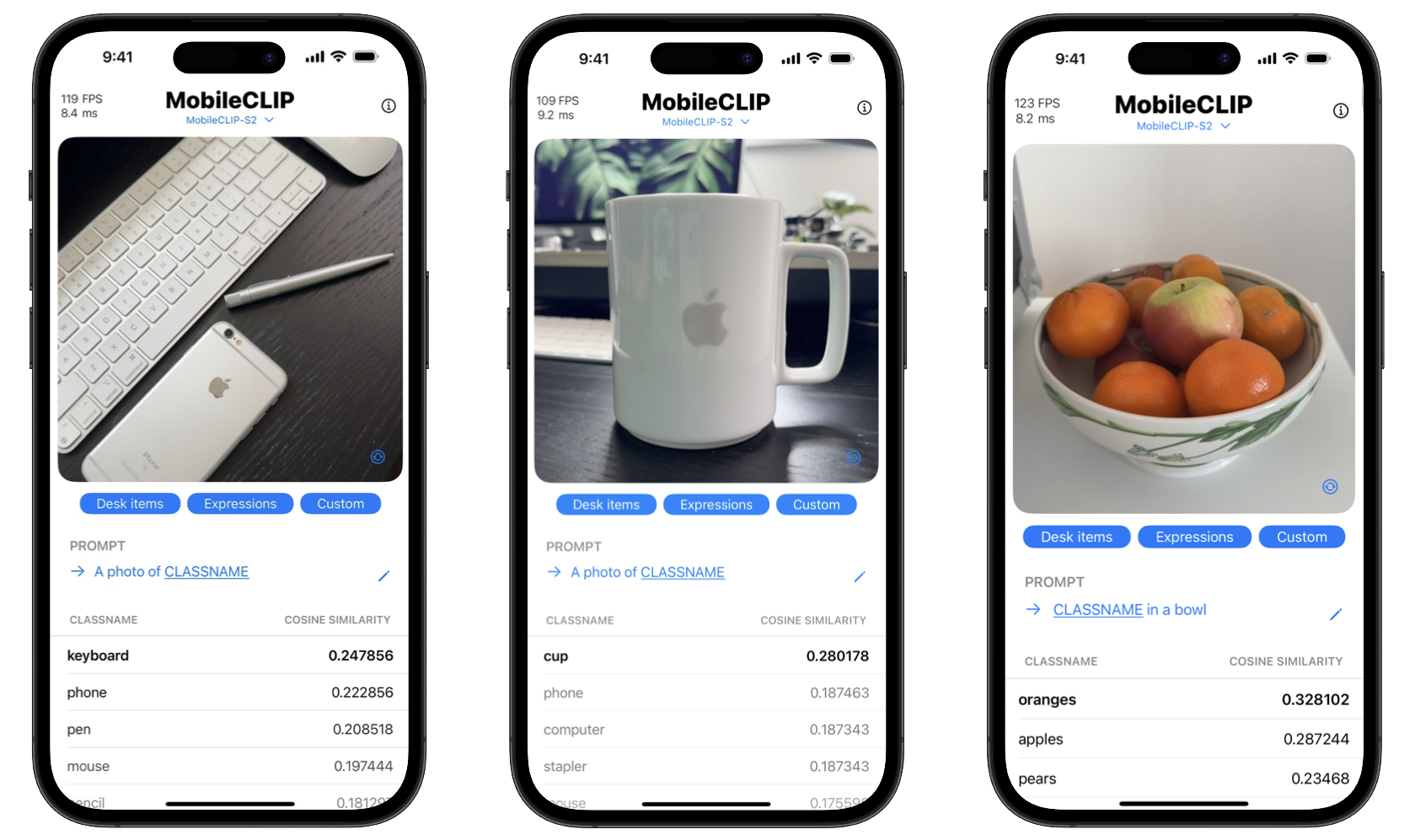

من خلال فتح مصدر هذه الأدوات، تمكّن آبل المطورين من بناء ميزات ذكاء اصطناعي متطورة كانت في السابق ممكنة فقط مع خوادم سحابية قوية. هذا يعني أن التطبيقات يمكنها أداء مهام معقدة مثل التعرف على الكائنات في الوقت الفعلي والبحث المرئي والتعليق المتقدم على الصور مباشرة على جهاز المستخدم.

الفوائد للمستهلكين ذات شقين: الخصوصية والسرعة. تعني المعالجة على الجهاز أن البيانات الحساسة مثل الصور الشخصية لا تضطر أبدًا إلى مغادرة الهاتف. علاوة على ذلك، تكون الإجراءات فورية، دون تأخير إرسال البيانات من وإلى الخادم. يتضمن المشروع حتى تطبيقًا تجريبيًا لنظام iOS لعرض إمكانات التصنيف في الوقت الفعلي هذه.

ابدأ مع MobileCLIP

يمكن للمطورين البدء في تجربة MobileCLIP على الفور. النماذج متاحة على Hugging Face، ويمكن العثور على الكود المصدري الكامل ونصوص التدريب وأدوات التقييم في مستودع GitHub الرسمي.

تثبيت سريع

conda create -n clipenv python=3.10

conda activate clipenv

pip install -e .