मोबाइल AI परिदृश्य में एक महत्वपूर्ण कदम में, एप्पल के शोधकर्ताओं ने MobileCLIP और इसके शक्तिशाली उत्तराधिकारी, MobileCLIP 2 को ओपन-सोर्स किया है। ये छवि-पाठ मॉडल उल्लेखनीय दक्षता के साथ डेस्कटॉप-श्रेणी का प्रदर्शन देने के लिए इंजीनियर किए गए हैं, जो बुद्धिमान, उत्तरदायी और निजी ऑन-डिवाइस अनुप्रयोगों की एक नई पीढ़ी के लिए मार्ग प्रशस्त करते हैं।

यह परियोजना, जिसका विवरण CVPR 2024 और प्रतिष्ठित TMLR जर्नल के पत्रों में दिया गया है, AI में एक महत्वपूर्ण चुनौती को हल करने पर केंद्रित है: सटीकता का त्याग किए बिना शक्तिशाली मॉडल को इतना छोटा और तेज़ बनाना कि वे सीधे मोबाइल उपकरणों पर चल सकें। कोड, पूर्व-प्रशिक्षित मॉडल और डेटासेट का पूरा सूट अब GitHub और Hugging Face पर जनता के लिए उपलब्ध है।

एक नज़र में प्रदर्शन

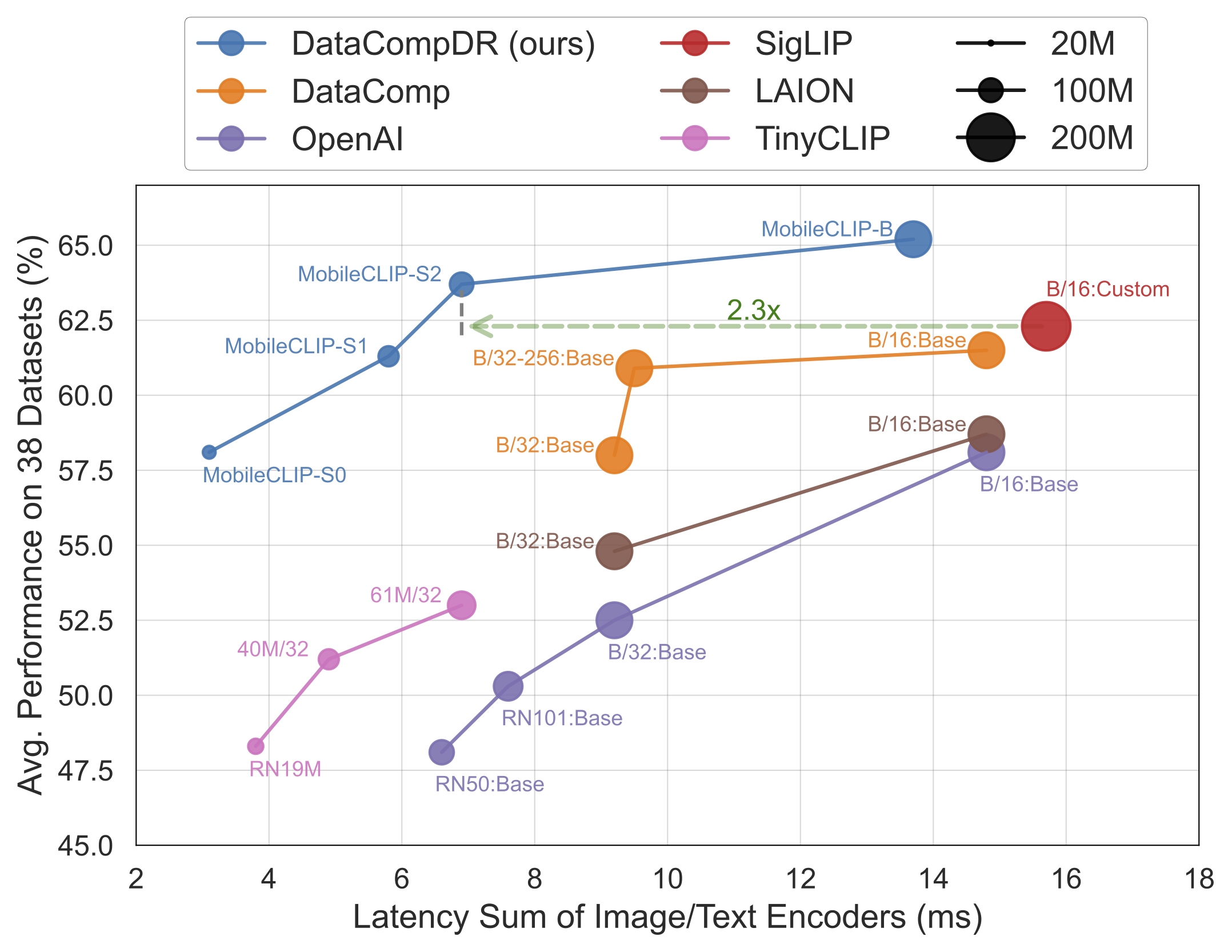

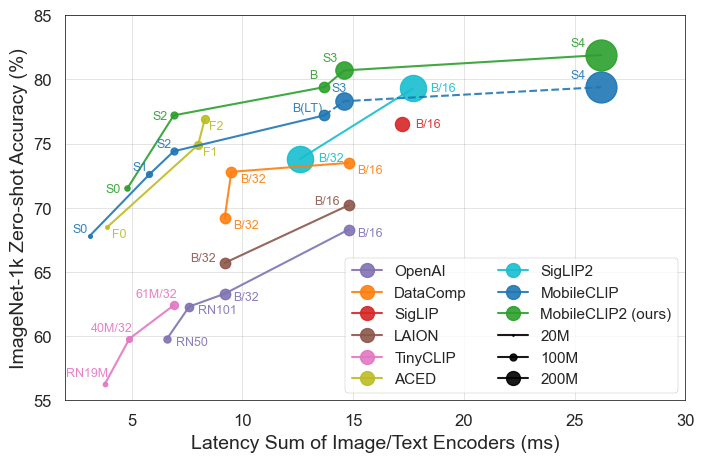

परिणाम खुद बोलते हैं। MobileCLIP मॉडल iPhone 12 Pro Max जैसे मोबाइल हार्डवेयर पर काफी तेजी से चलते हुए लगातार बड़े, अधिक कम्प्यूटेशनल रूप से महंगे मॉडल से बेहतर प्रदर्शन करते हैं या मेल खाते हैं।

रिलीज़ की मुख्य विशेषताएँ

- चरम दक्षता: सबसे छोटा मॉडल,

MobileCLIP-S0, OpenAI के व्यापक रूप से उपयोग किए जाने वाले ViT-B/16 मॉडल के समान प्रदर्शन प्राप्त करता है, लेकिन यह 4.8 गुना तेज़ और 2.8 गुना छोटा है। - अत्याधुनिक गति:

MobileCLIP2-S4आधे मापदंडों के साथ शक्तिशाली SigLIP-SO400M/14 मॉडल की सटीकता से मेल खाता है और 2.5x कम विलंबता के साथ DFN ViT-L/14 से आगे निकल जाता है। - सफलतापूर्ण प्रशिक्षण: मॉडल को नए विकसित डेटासेट (DataCompDR और DFNDR) पर एक नई "मल्टी-मोडल रीइन्फोर्स्ड ट्रेनिंग" तकनीक का उपयोग करके प्रशिक्षित किया जाता है, जो उनकी बढ़ी हुई दक्षता में एक महत्वपूर्ण कारक है।

- डेवलपर-अनुकूल: मॉडल अब लोकप्रिय OpenCLIP लाइब्रेरी में मूल रूप से समर्थित हैं, जिससे उन्हें मौजूदा परियोजनाओं में एकीकृत करना आसान हो जाता है।

तकनीकी गहरा गोता

MobileCLIP का प्रभावशाली प्रदर्शन कई प्रमुख नवाचारों से उपजा है:

- मल्टी-मोडल रीइन्फोर्स्ड ट्रेनिंग: एक नई प्रशिक्षण रणनीति जो छवियों और पाठ को प्रभावी ढंग से जोड़ने की मॉडल की क्षमता को बढ़ाती है, जिससे कम संसाधनों के साथ उच्च सटीकता प्राप्त होती है।

- विशेष रूप से क्यूरेटेड डेटासेट: मॉडल को

DataCompDRऔरDFNDRपर प्रशिक्षित किया गया था, जो छवि-पाठ मॉडल की मजबूती और दक्षता में सुधार के लिए विशेष रूप से बड़े पैमाने पर उत्पन्न किए गए विशाल डेटासेट हैं। - कुशल मोबाइल आर्किटेक्चर: मॉडल में विज़न टावर MobileOne जैसे कुशल आर्किटेक्चर पर आधारित हैं, जो मोबाइल CPU और GPU पर उच्च प्रदर्शन के लिए अनुकूलित हैं।

यह डेवलपर्स और उपभोक्ताओं के लिए क्यों मायने रखता है

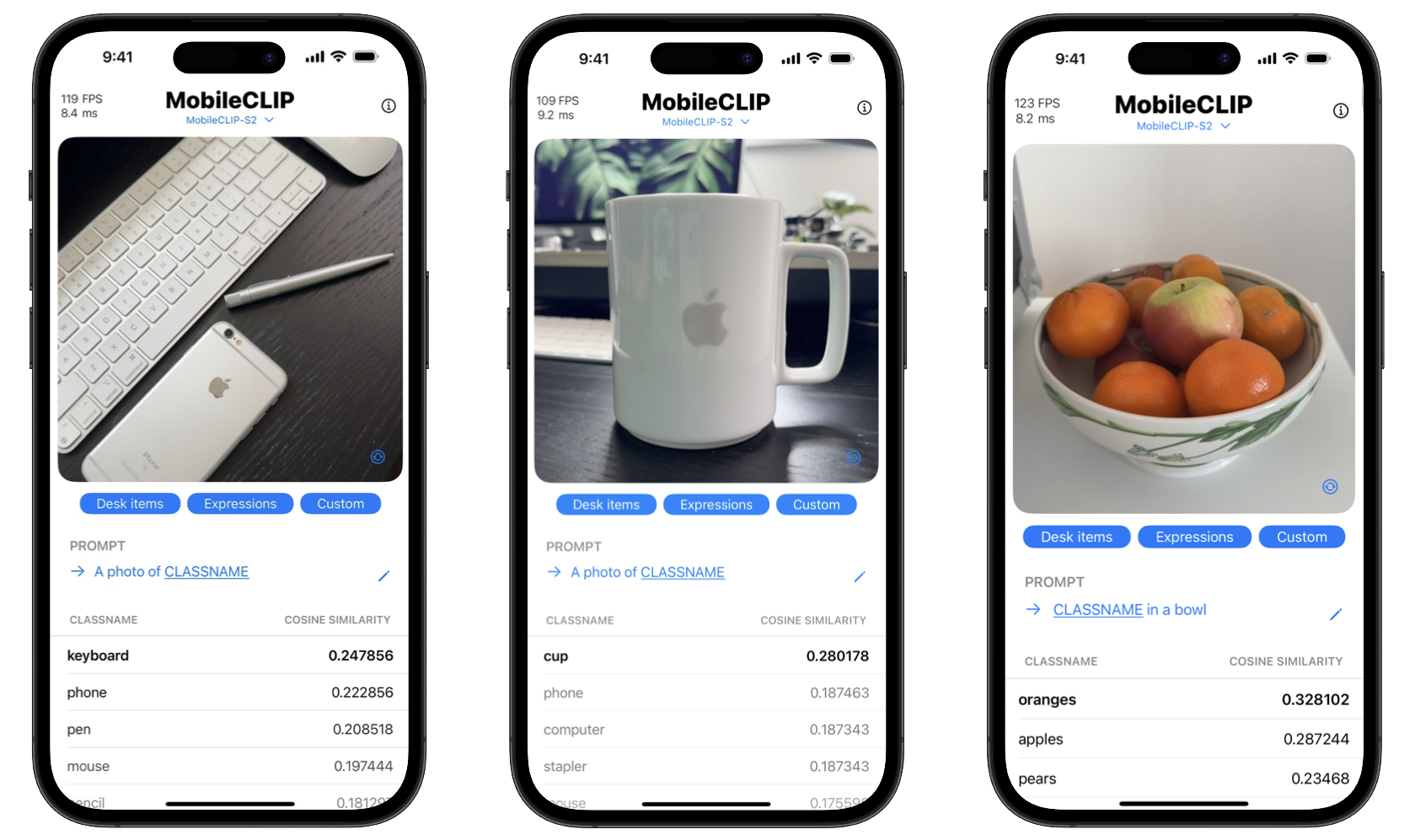

इन उपकरणों को ओपन-सोर्स करके, एप्पल डेवलपर्स को परिष्कृत AI सुविधाएँ बनाने के लिए सशक्त बना रहा है जो पहले केवल शक्तिशाली क्लाउड सर्वर के साथ ही संभव थीं। इसका मतलब है कि ऐप्स वास्तविक समय में वस्तु पहचान, विज़ुअल सर्च और उन्नत छवि कैप्शनिंग जैसे जटिल कार्यों को सीधे उपयोगकर्ता के डिवाइस पर कर सकते हैं।

उपभोक्ताओं के लिए लाभ दो गुना हैं: गोपनीयता और गति। ऑन-डिवाइस प्रोसेसिंग का मतलब है कि व्यक्तिगत तस्वीरों जैसा संवेदनशील डेटा कभी भी फोन छोड़ने की आवश्यकता नहीं है। इसके अलावा, क्रियाएं तात्कालिक होती हैं, सर्वर पर डेटा भेजने और प्राप्त करने में कोई देरी नहीं होती है। परियोजना में इन वास्तविक समय वर्गीकरण क्षमताओं को प्रदर्शित करने के लिए एक iOS डेमो ऐप भी शामिल है।

MobileCLIP के साथ शुरुआत करें

डेवलपर्स तुरंत MobileCLIP के साथ प्रयोग करना शुरू कर सकते हैं। मॉडल Hugging Face पर उपलब्ध हैं, और पूरा स्रोत कोड, प्रशिक्षण स्क्रिप्ट और मूल्यांकन उपकरण आधिकारिक GitHub रिपॉजिटरी में पाए जा सकते हैं।

त्वरित स्थापना

conda create -n clipenv python=3.10

conda activate clipenv

pip install -e .