Comment ça marche ?

FastVLM comprend efficacement le contenu de l'image, le convertit en jetons compacts, puis utilise ces jetons pour générer rapidement des descriptions textuelles précises ou des réponses.

Avantages Clés

Vitesse Extrême

Vitesse de sortie du premier jeton étonnante ! FastVLM-0.5B est 85 fois plus rapide que LLaVA-OneVision. FastVLM-7B (avec Qwen2) est 7.9 fois plus rapide que Cambrian-1-8B (avec une précision similaire).

Compact et Efficace

Petite taille de modèle, déploiement plus facile. FastVLM-0.5B est 3.4 fois plus petit que LLaVA-OneVision. Idéal pour une utilisation sur appareil comme l'iPhone, l'iPad, le Mac.

Intelligence sur l'Appareil

Aucune dépendance au cloud, fonctionne directement sur votre appareil Apple, protégeant la confidentialité et répondant plus rapidement.

Parfaitement adapté à l'écosystème iOS/Mac, renforçant les applications d'IA en périphérie.

Exemples

Comptage d'Objets

Reconnaissance d'Écriture Manuscrite

Compréhension d'Emoji

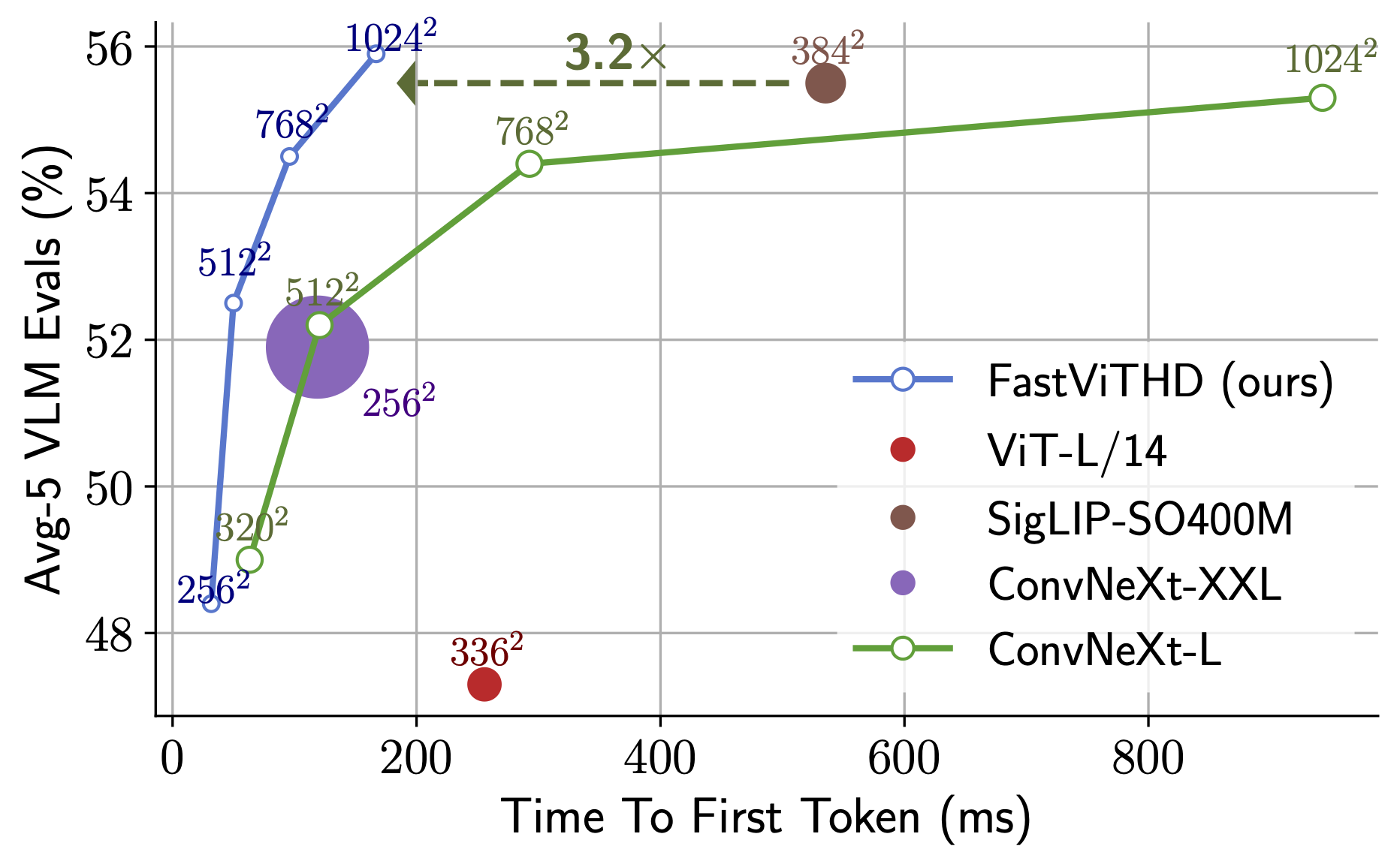

Comparaison des Performances

Scénarios d'Application

Légendage d'Images

Générez automatiquement des descriptions textuelles vives et précises pour les images.

Réponse Visuelle aux Questions (VQA)

Comprenez le contenu de l'image et répondez aux questions concernant l'image.

Reconnaissance et Analyse d'Images

Reconnaissez les objets, le texte ou les données dans les images pour une analyse intelligente.

Particulièrement adapté aux scénarios nécessitant une interaction image et texte en temps réel.

Téléchargements de modèles

Checkpoints PyTorch

| Modèle | Étape | Lien de téléchargement |

|---|---|---|

| FastVLM-0.5B | 2 | fastvlm_0.5b_stage2 |

| FastVLM-0.5B | 3 | fastvlm_0.5b_stage3 |

| FastVLM-1.5B | 2 | fastvlm_1.5b_stage2 |

| FastVLM-1.5B | 3 | fastvlm_1.5b_stage3 |

| FastVLM-7B | 2 | fastvlm_7b_stage2 |

| FastVLM-7B | 3 | fastvlm_7b_stage3 |

Modèles compatibles Apple Silicon

Pour faciliter l'exécution sur les appareils Apple Silicon, nous fournissons des modèles dans des formats pré-convertis :